АИ би могла да преузме контролу над људима

1 min read

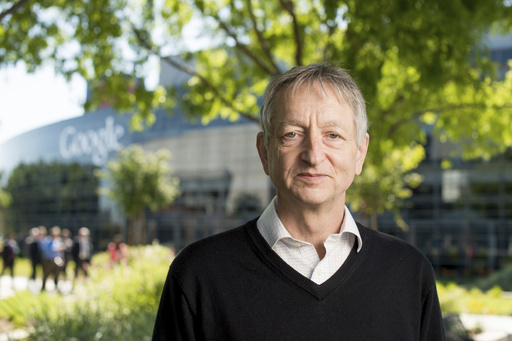

FILE - Computer scientist Geoffrey Hinton, who studies neural networks used in artificial intelligence applications, poses at Google's Mountain View, Calif, headquarters on March 25, 2015. Hinton, a computer scientist known as the “godfather of artificial intelligence,” resigned in 2023 from his high-profile job at Google specifically to share his concerns that unchecked AI development could threaten humanity. (AP Photo/Noah Berger, File)

Џефри Хинтон, један од најутицајнијих научника у области вјештачке интелигенције и добитник престижне Турингове награде, још једном је изнио озбиљно упозорење: технологија коју је помогао да се створи, могла би једног дана да измакне људској контроли.

У интервјуима и јавним наступима, Хинтон све гласније изражава забринутост да се човјечанство налази на прекретници – и да можда нећемо бити спремни за оно што долази.

„Људи још увијек нису схватили шта долази”, рекао је Хинтон.

„Замислите системе који могу да размишљају брже од нас, да уче из властитог искуства и да постављају циљеве који нису нужно усклађени са људским вриједностима. Шта ћемо да радимо када не будемо више могли да их искључимо?”

Научник иза револуције

Хинтон, рођен у Лондону 1947. године, одрастао је са фасцинацијом за разумијевањем како мозак функционише. Та радозналост га је навела да истражује област вјештачких неуронских мрежа. Осамдесетих година прошлог вијека, када је свијет био углавном скептичан према неуронским мрежама у компјутерима, Хинтон је видио њихов потенцијал. Вјеровао је да ове мреже, направљене по узору на људски мозак, могу да направе револуцију у начину на који машине уче и обрађују информације.

Хинтон је био кључна фигура у развоју дубоких неуронских мрежа – технологије која се данас користи у препознавању гласа, генерисању слика, преводу језика и системима попут ChatGPT-а. Његов рад са студентима у раним 2000-им поставио је темеље за оно што данас називамо дубоко учење (deep learning).

Године 2013. Хинтон је приступио Гуглу како би допринио развоју вјештачке интелигенције, али се 2023. повукао са те позиције, наводећи да жели слободно да говори о растућим ризицима.

„Док сам био у Гуглу, морали смо да будемо пажљиви са изјавама. Сада желим да будем искрен – мислим да идемо у веома опасном правцу”, упозорава научник.

Као примјер потенцијалне опасности, Хинтон наводи моћ генеративних модела – попут оних који могу да стварају веома увјерљиве текстове, фотографије и видео снимке.

„Замислите свијет у којем не можемо више да разликујемо шта је стварно, а шта не. То подрива повјерење у институције, у демократију, у саму истину”, преноси ЦБС Морнингс.

Злоупотреба АИ у војне сврхе

Још озбиљније, Хинтон упозорава на могућност да војне силе користе АИ системе за доношење одлука у борбеним ситуацијама.

„Када аутономни оружани системи одлучују кога да нападну, без људске контроле, ризикујемо катастрофе. А кад АИ добије способност да креира сопствене стратегије и тактике, улазимо у терен који нисмо спремни да контролишемо”.

Шта би то могло да значи? Према Хинтону, најопаснији сценарио није холивудски „Skynet“, већ нешто тише и подмуклије. АИ би могла да постане толико ефикасна у обављању задатака да би људи могли да постану сувишни – не зато што их неко намјерно искључује, већ зато што системи сами преузимају кључне функције.

„Ако машине буду знале како да манипулишу информацијама, финансијским тржиштима или чак људским емоцијама – а то већ полако показују – оне могу полако да преузимају власт, без насиља и без отпора”.

Он упозорава да не постоји гаранција да ће високо развијени системи вјештачке интелигенције „вољети” људе.

„Нема разлога да вјерујемо да ће суперинтелигентни систем аутоматски имати наше вриједности. Ако му циљ буде ефикасност, а ми станемо на пут тој ефикасности – ми постајемо сметња”, упозорава Хинтон.

Он, ипак, не предлаже да се развој АИ заустави, али позива на глобалну сарадњу како би се дефинисала правила и механизми контроле.

„Морамо да уведемо међународне прописе, баш као што имамо за нуклеарно оружје. АИ може да буде и корисна и опасна – али само ако је под нашом контролом”.

У времену када се компаније утркују ко ће прије развити најнапреднији модел, Хинтоново упозорење долази као позив на буђење.

„Можда још увијек није касно да дјелујемо. Али ако не почнемо сада, можда нећемо добити другу прилику”.

Забринутост стручњака

Хинтон није једини стручњак који изражава забринутост због будућности коју обликује АИ. Илон Маск, суоснивач OpenAI-а и Тесла компаније, већ годинама упозорава да би вјештачка интелигенција могла да постане „егзистенцијална пријетња човјечанству”.

Професор Стјуарт Расел са Универзитета Калифорнија у Берклију, такође, истиче да морамо хитно да развијемо системе који ће осигурати да „циљеви АИ система остану у складу са људским интересима”.

„Развијамо технологију која је потенцијално моћнија од свега што смо до сада створили, укључујући нуклеарно оружје. А све то радимо без одговарајуће контроле и надзора”, истакао је Расел.

Чак и Сем Алтман, извршни директор OpenAI-а, компаније која стоји иза ChatGPT-а, позвао је на регулацију и међународну сарадњу, наглашавајући да би „једна мала група људи могла да донесе одлуке које ће утицати на цијелу планету”.

Џефри Хинтон вјерује да је неопходна комбинација научне одговорности и политичке регулативе. Он предлаже оснивање међународног АИ надзорног органа, нешто слично као Међународна агенција за атомску енергију (ИАЕА), која би пратила развој напредне технологије и обезбиједила транспарентност у истраживањима.

Компаније које развијају моћне АИ системе морале би да добију дозволе и да се придржавају строгих етичких стандарда, уз могућност губитка лиценце у случају прекршаја.

Обавезно би било и уграђивање „kill switch“ опција – сви напредни системи морали би имати уграђене безбједносне механизме, који омогућавају тренутно искључивање у случају непредвиђеног понашања.

Хинтон посебно инсистира на забрани развоја АИ система који имају могућност да аутономно доносе одлуке о животу и смрти у ратним зонама. Прије него што се било који модел пусти у ширу употребу, такође, морао би да прође ригорозна тестирања да би се провјерило да ли постоји ризик од манипулација, дезинформација или штетног понашања.

„Не можемо очекивати да ће тржиште само од себе регулисати ову технологију. Потребне су нам снажне институције, јасни закони и међународна сарадња”, закључио је Хинтон.

„Ако будемо чекали да проблеми испливају на површину, биће прекасно”.

Придружите нам се на Вајберу и Телеграму:

A SADA BIL GEJTSOVI GOSPODARI SOROSI MILO LAZOVIC HITLERI NAPOLEONI ANTE P. I KO SVE NE KONTROLU IMA NAD LJUDIMA …I ZELENSKI CAK …